남는 m4 맥미니에 로컬 LLM으로 설정을 해봤는데

동작은 됩니다만 제대로 사용하려면 API 결제를 통해서 사용해야겠다 싶네요

LM스튜디오는 안되고 ollama로는 쉽게 사용 가능하더라고요

Qwen 3 4b, 8b 모델 사용해봤는데 딜레이가 꽤 깁니다

설정을 디테일하게 조절을 해보면 나아질 수 있겠지만

m4 맥미니 한계가 있어서 큰 기대는 안됩니다

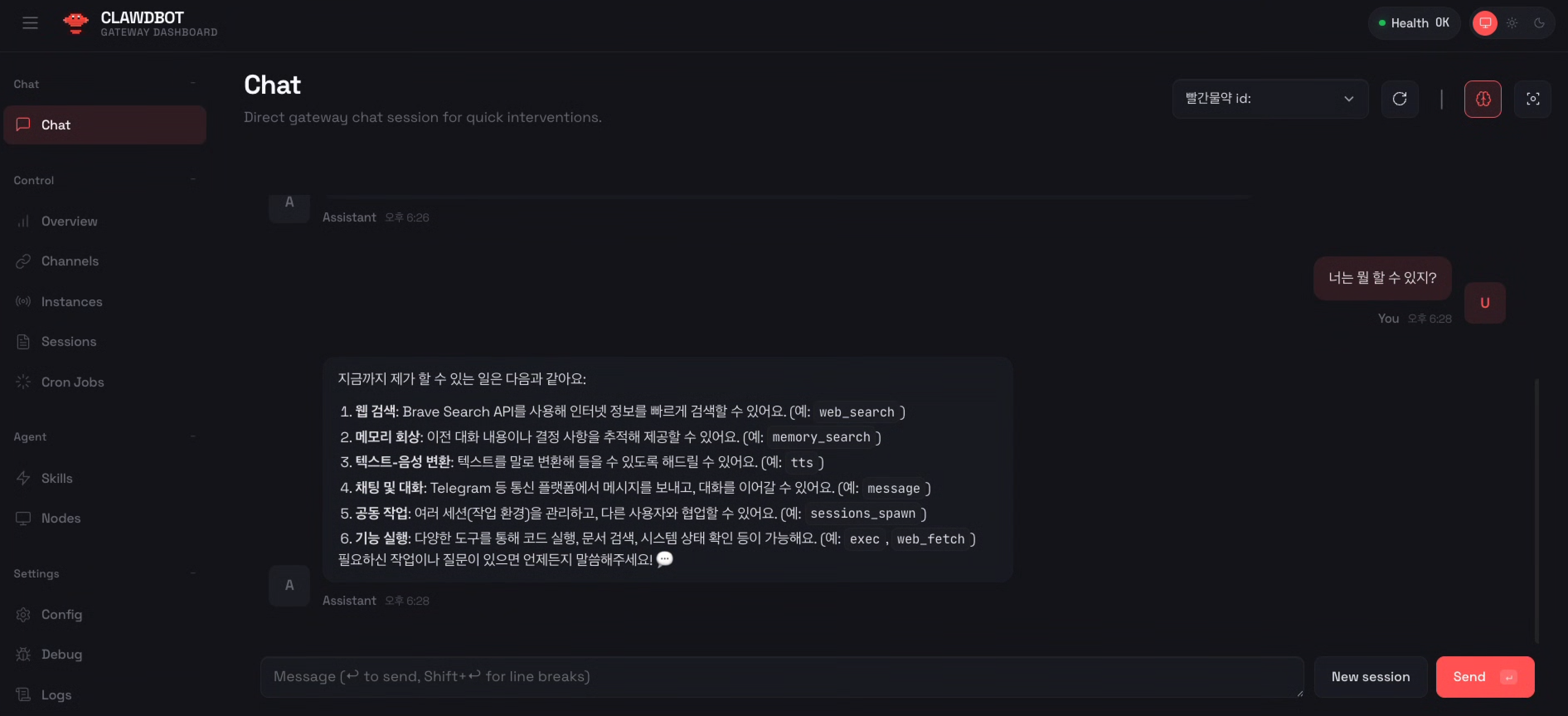

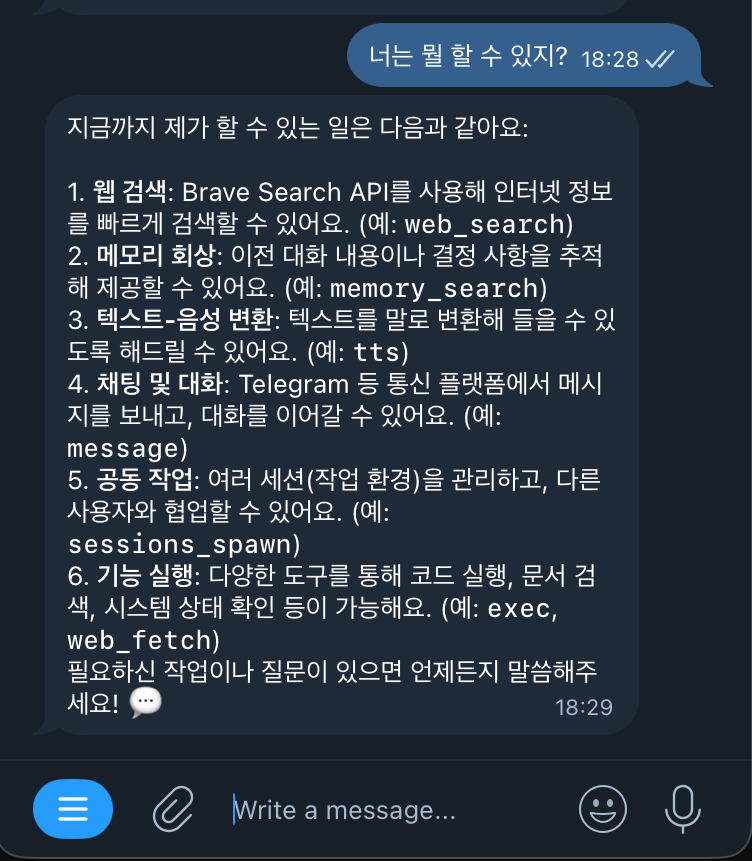

그리고 여러가지 도구 설정을 해야 제대로 사용가능한데

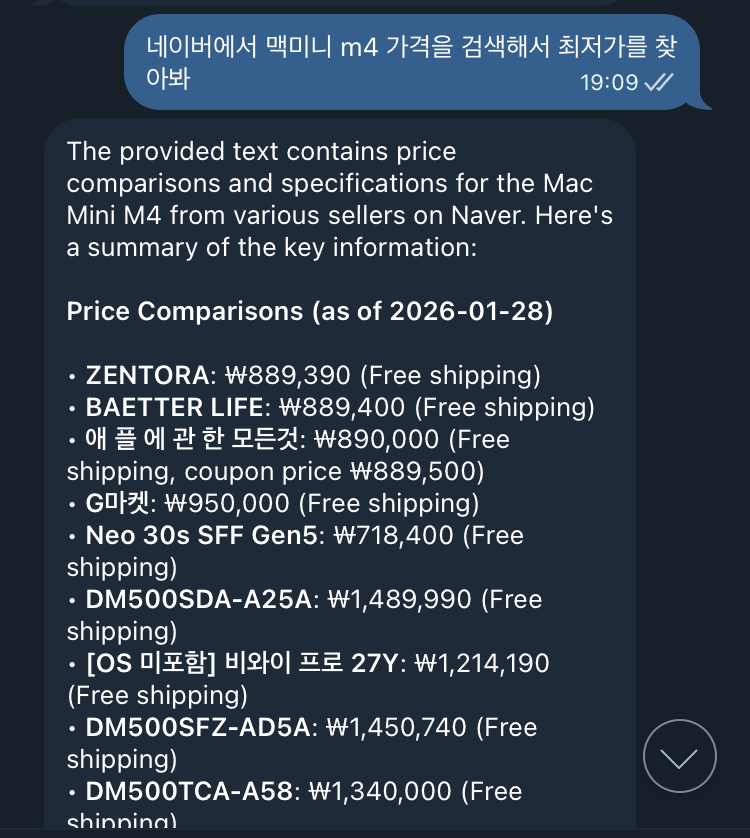

웹 검색 같은 경우 브레이브 api나 퍼플렉시티 api를 입력해서 사용하거나

클로드 전용 브라우저 설정이나 피씨 브라우저에

확장 프로그램 설정을 해서 사용할 수 있는 거 같습니다

최적화 없이 대충 설정을 하고 테스트 해보는데

이정도 기능은 사용 가능한 거 같습니다

실시간으로 바로바로 답을 받아보는 건 맥미니 로컬 LLM 성능 문제로 좀 힘들고

지시 내려 놓으면 텔레그램으로 알림이 오니까 나중에 확인 하는 방식으로 활용은 가능할 거 같습니다

스크래핑이나 그런 부분도 가능하다고 하니 기간이나 시간 정해서 설정하고 뭐 그런식으로 사용할 수 있겠네요

그나저나 clawdbot으로 설치해서 다 세팅했는데 moltbot으로 이름이 바꼈더라고요 openclaw로 또 바뀜

클로드에서 태클 걸어서 그렇다는 이야기가 있다는데 이거 다시 세팅하려니 귀찮네요

moltbot으로 설치해도 실행은 clawdbot으로 되는 거 같고 지금 좀 정리가 안된 느낌이긴 합니다