얼마전에 북마크 서비스를 설치 했었습니다

며칠 동안 사용을 해보니까 나쁘지않습니다

기능 중에 ai 태그 생성 기능이 있는데

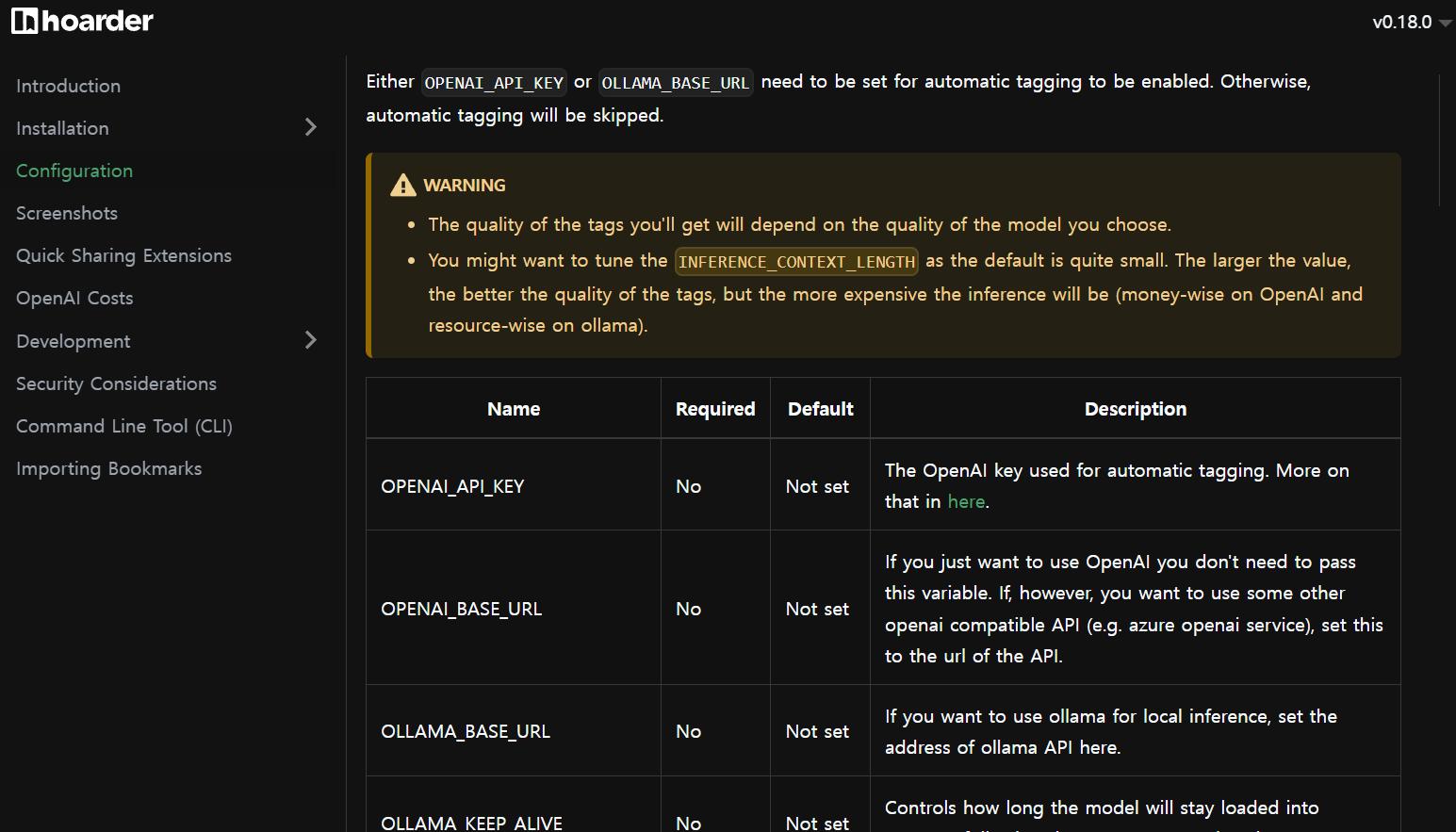

기본 적으로 open ai 를 지원하고 호환 가능한 azure open ai와 ollama를 지원 하더라고요

그런데 open ai 무료 플랜은 사용이 안되는 거 같습니다

그럼 로컬로 돌려보자 해서 n100 s12pro에 ollama를 설치 해보기로 했습니다

설치는 정말 간단

설치는 간단 합니다

docker/ollama 폴더 생성 후 위의 코드로 프로젝트 생성 하면 끝

뭐 따로 설정하고 말고 할 것도 없습니다 gui도 없습니다

어차피 ai 태그 생성용으로 사용 할 거니까 gui필요 없겠죠

gui로 챗 gpt처럼 사용해보고 싶다면

이런 거 하나 설치 해주시면 됩니다

이것도 간단

이건 뭐 볼륨 매핑도 필요 없습니다

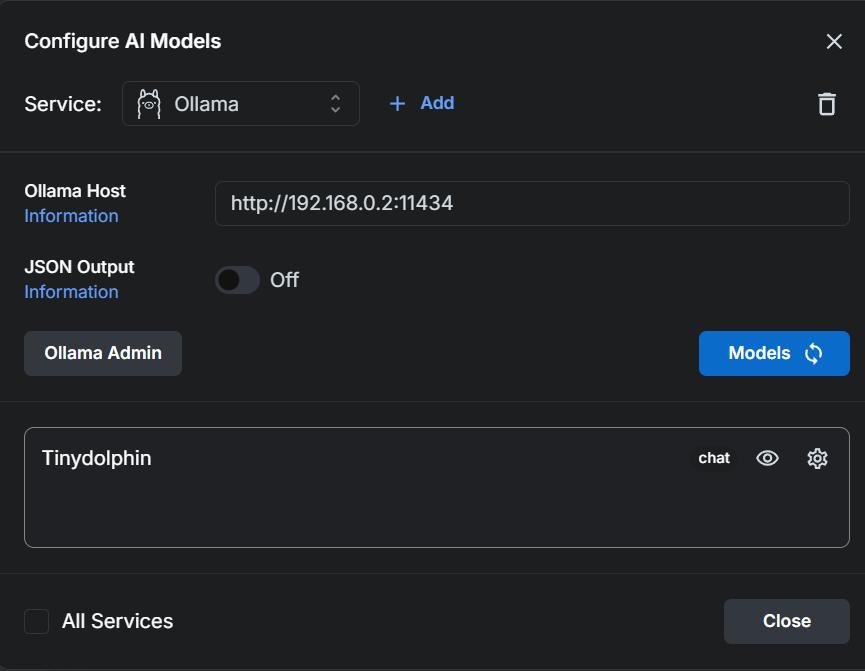

생성 후 아이피:포트로 접속 해서 모델 설정 하실 때 add 버튼 클릭 후 ollama선택

ollama 컨테이너 아이피:포트 넣고 Ollama Admin 버튼 누르고

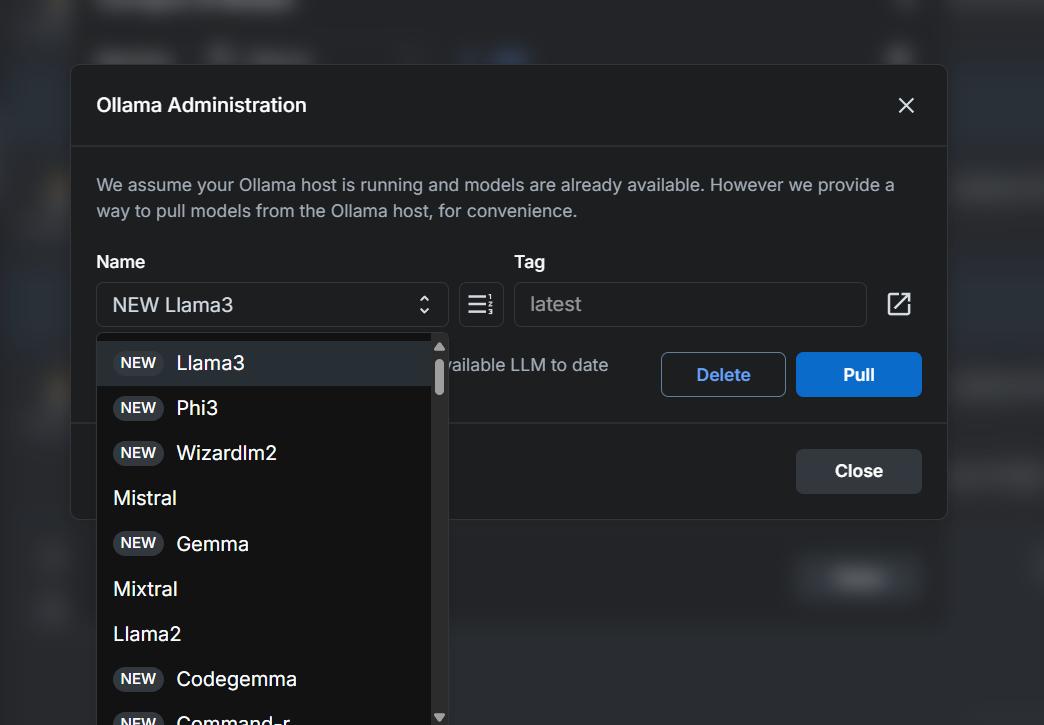

모델 명과 태그 선택 후 Pull 버튼 클릭

모델 종류는

링크에 있습니다

서버 성능이나 사용 목적에 따라 모델을 선택하면 됩니다

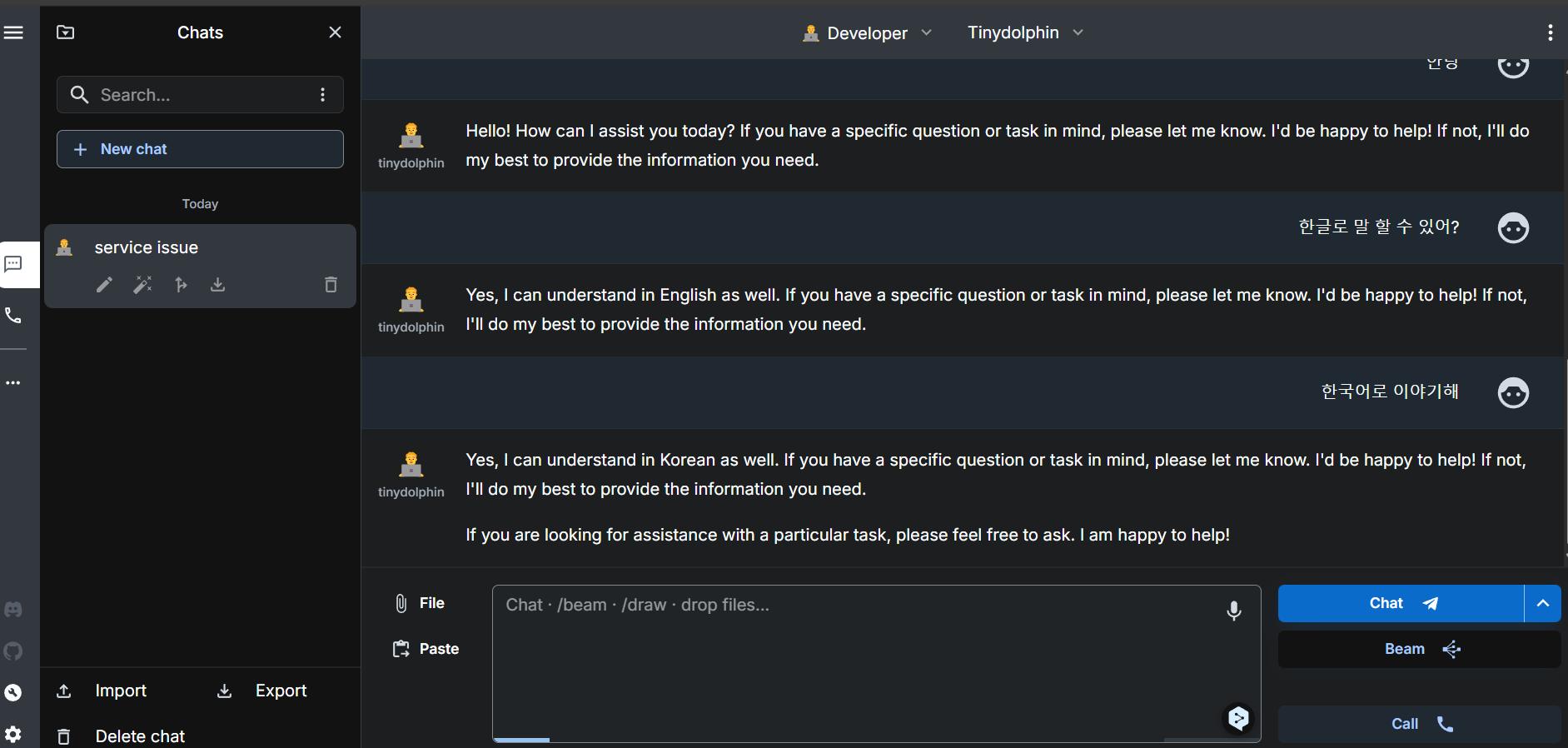

어쨌든 설정을 하면

로컬ai는 한국어를 좀 하던데….

채팅이 가능 합니다만

뭐 그렇습니다 가벼운 모델 선택해서 해봤는데 n100 서버라 시간도 오래걸리고

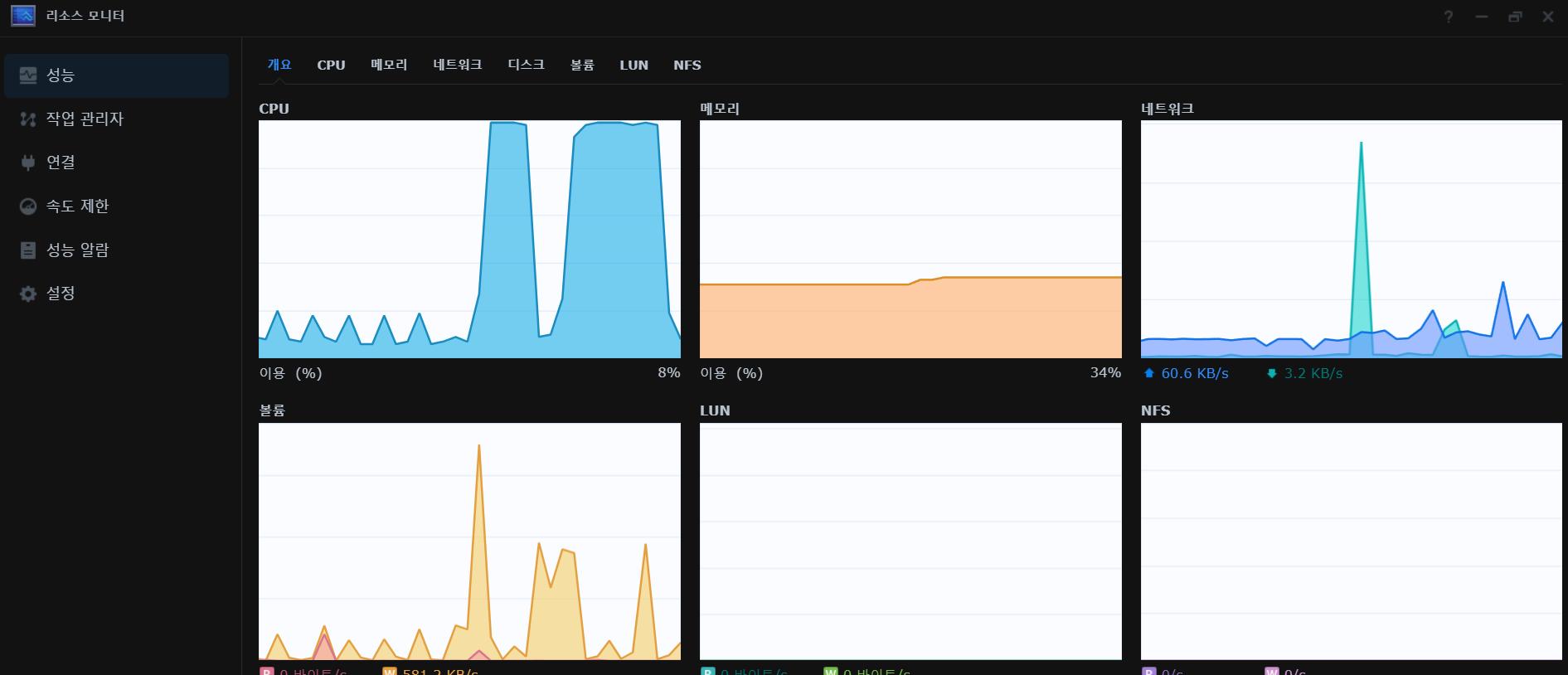

서버도 살려달라고 소리 칩니다

살려줘….

어쨌든 채팅은 좀 그래도 ai 태그에 쓸 수는 있지 않을까?

했는데…

우선

hoarder .env 파일에 위의 코드를 추가 하시면 됩니다

ollama 주소와 선택 한 모델 그리고 AI가 로드 돼있는 시간과 기다리는 시간 등등 설정을 해주시면 됩니다

그 후 hoarder에 북마크를 하면 ai 태그를 생성 합니다

시간이 좀 걸려요…

그런데 태그 내용이 좀 뭔가 중구난방 ai모델을 가벼운 걸 써서 그런지 아니면 적당한 모델이 아닌지 모르겠지만

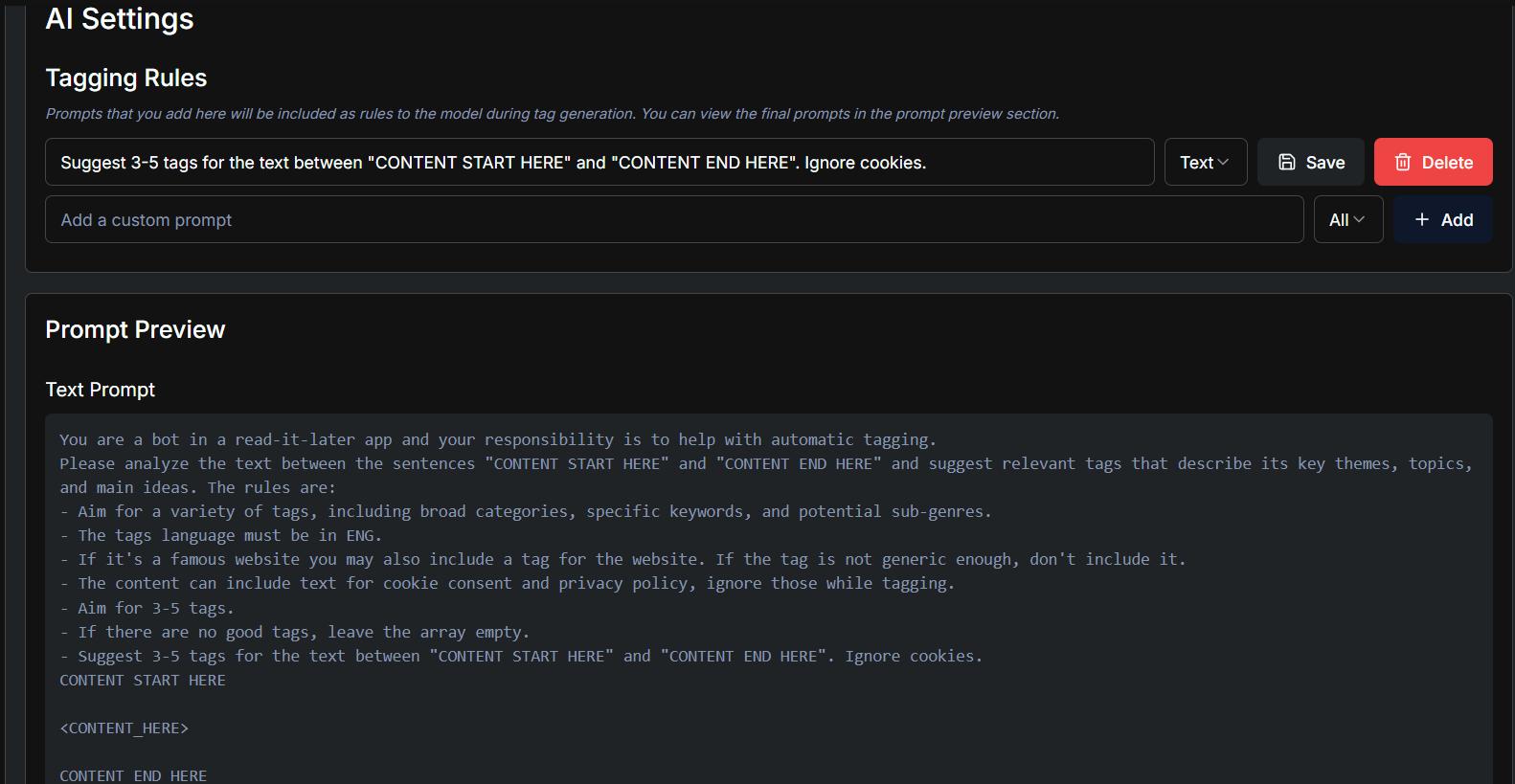

hoarder 설정에서 프롬프트도 설정을 해봅니다

뭔가 좀 많이 모자랍니다…

자원도 많이 먹습니다…

호기심에 테스트 해보긴 해봤지만 실사용은 좀 힘들다 라는 생각이 듭니다

결론은 그냥 open ai 결제해서 쓰는 게 좋다

ai 태그 만드는 것도 오래 걸리는데 다 이상해서 지우는데도 시간이 들어가니

그냥 끄고 쓰거나 open ai 결제 후 사용 하시길 바랍니다…

참고로 그래픽 카드가 설치 돼있는 서버를 사용 하시는 분들은 한 번쯤 시도 해보셔도 좋을 거 같습니다

저는 n100 모델이라 cpu온리 버전을 설치 했습니다

-추가-

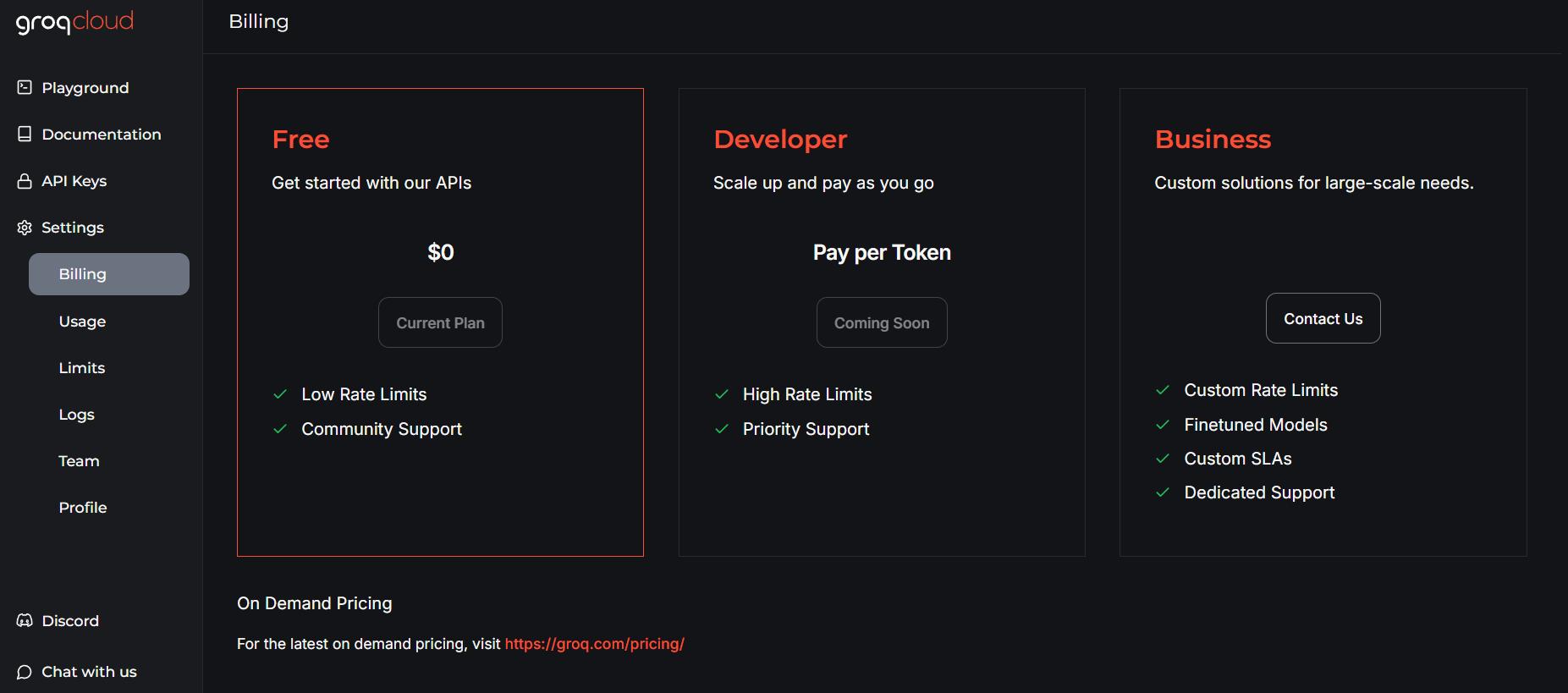

grog free tier도 가능할 거 같다는 댓글을 참고해서 테스트 해봤습니다

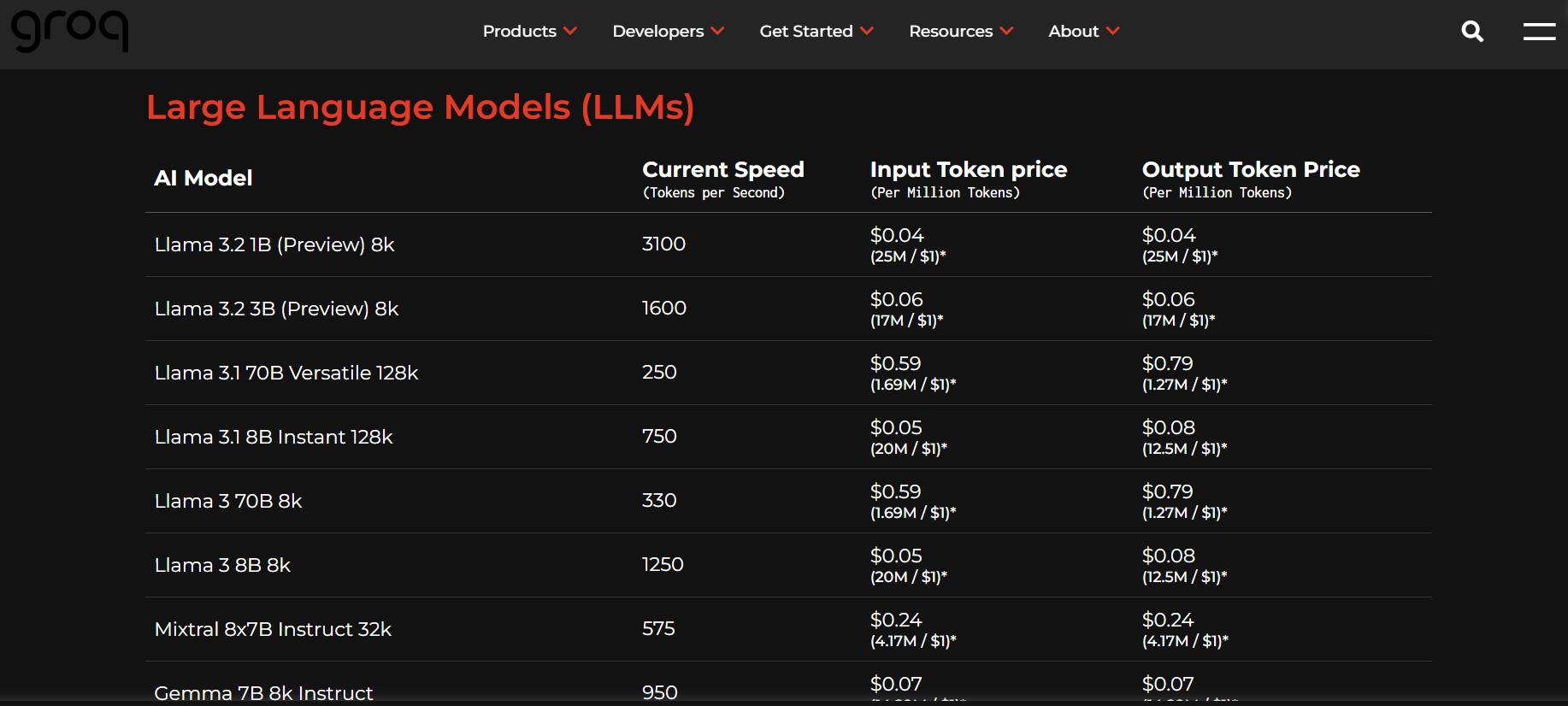

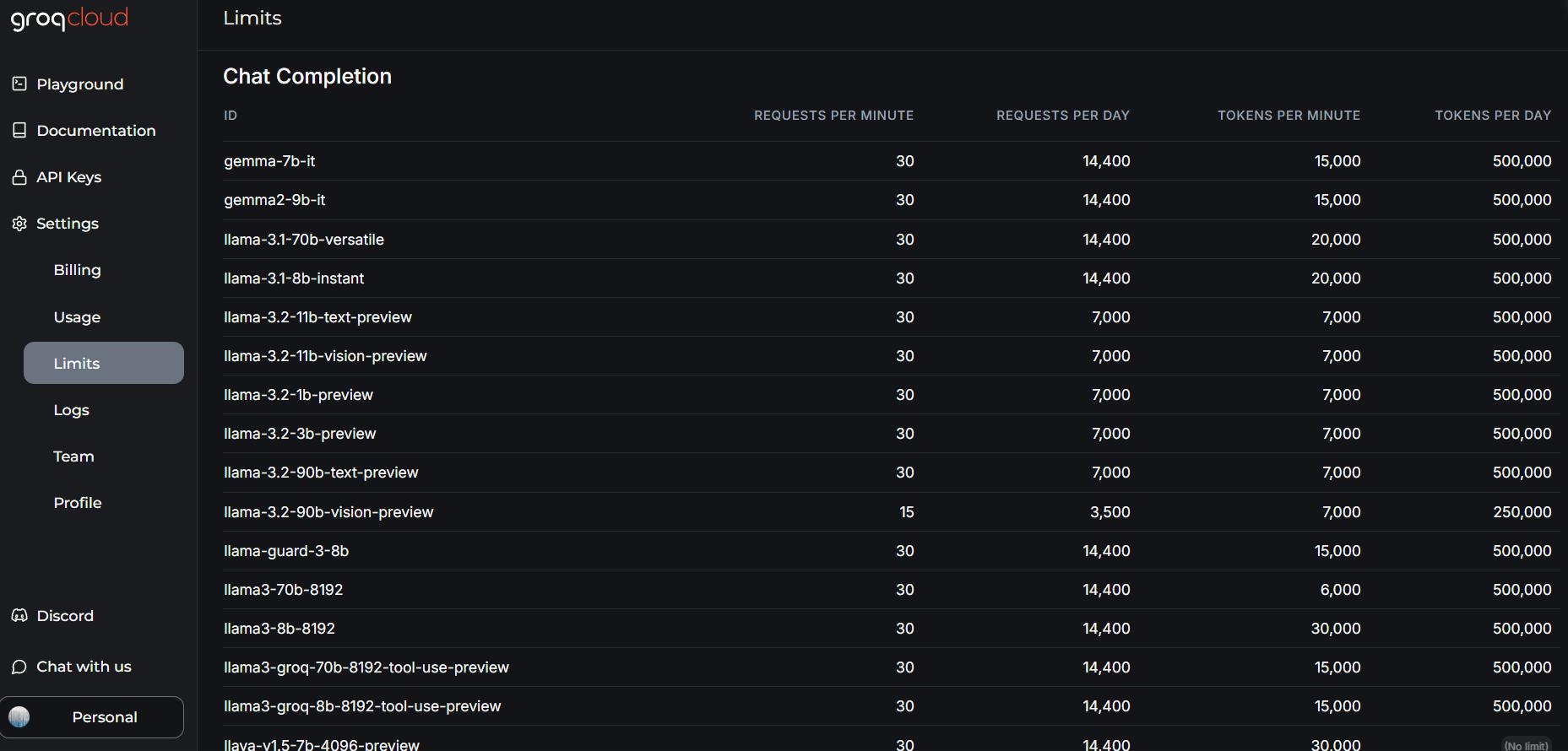

기본 가격과 사용량 제한

토큰 형식으로 사용 가능한 요금제 입니다

프리티어로 어느 정도 사용 가능할지는 모르겠지만 작동은 잘 되네요

hoarder의 .env 파일에 위와 같이 추가 해주시고 빌드 하시면 됩니다

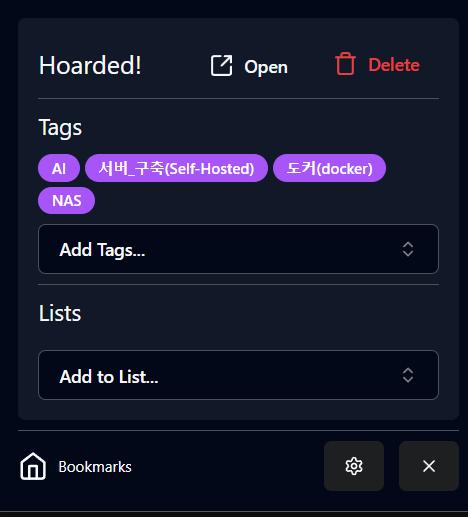

이 게시물을 북마크 했을 때 자동 생성 된 태그 입니다 잘 되네요

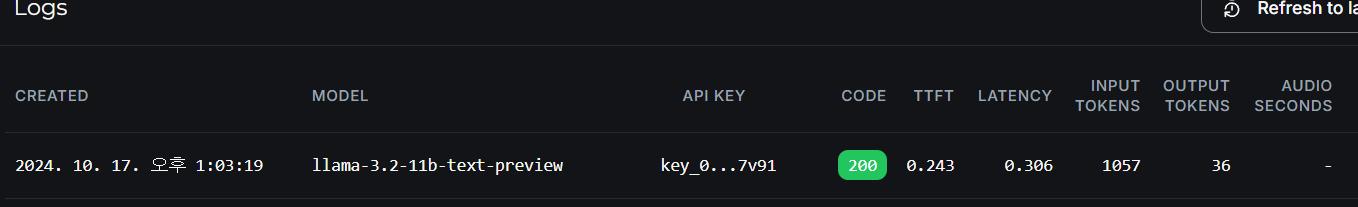

태그 1회 생성시 토큰 사용량은 이렇습니다

일일 50만 토큰 사용 가능한 거 같은데 1회 1000토큰 정도 사용하니까

대략 하루에 500번 정도 쓸 수 있을 거 같습니다만

페이지 내용에 따라 500~3000 까지도 왔다갔다 하는 거 감안하면

넉넉하게 잡았을 때 하루에 2~300번 정도 가능하지 않을까 싶습니다

혼자서 그냥 쓰기에는 딱 좋은 거 같네요