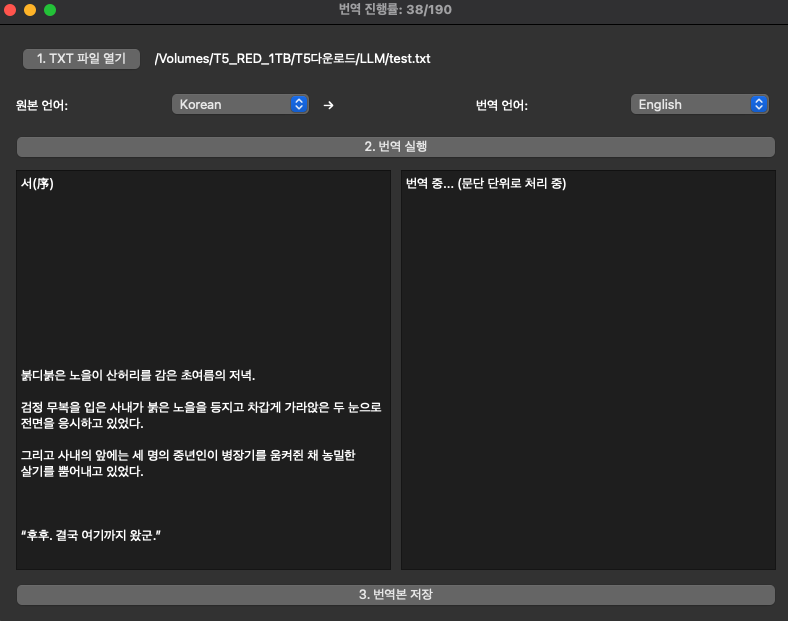

온디바이스 모델 Gemma 3n 을 어디에 써볼까 하다가

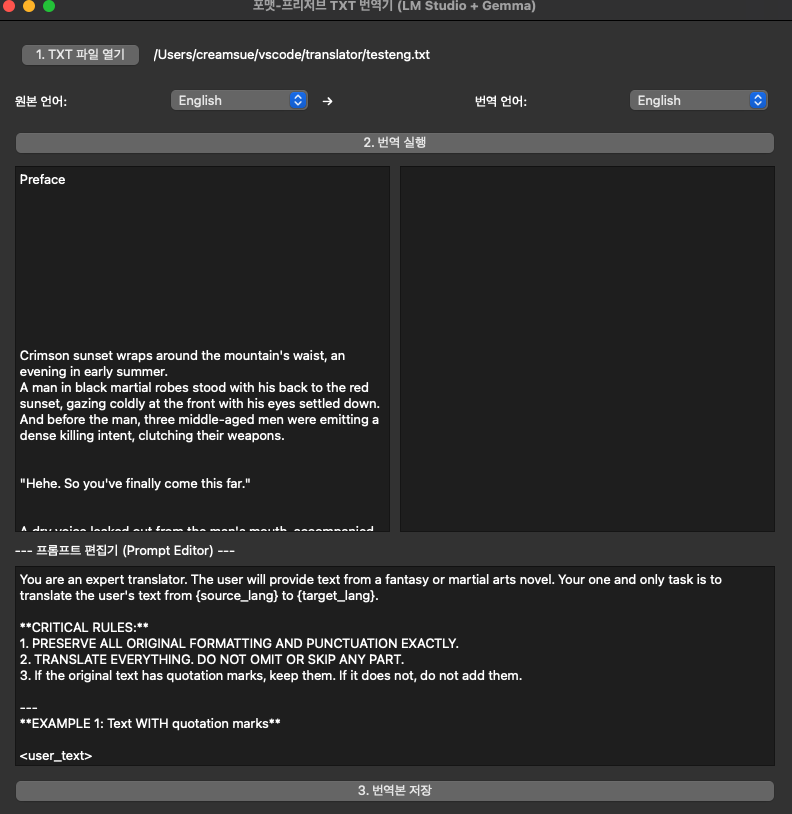

번역 프로그램이나 테스트 해보자 해서 간단하게 만들어 봤는데 나름 쓸만하네요

m4 맥미니 깡통에서 번역 속도도 그렇게 나쁘지는 않습니다만 퀄리티는 그럭저럭 쓸만한 정도 입니다

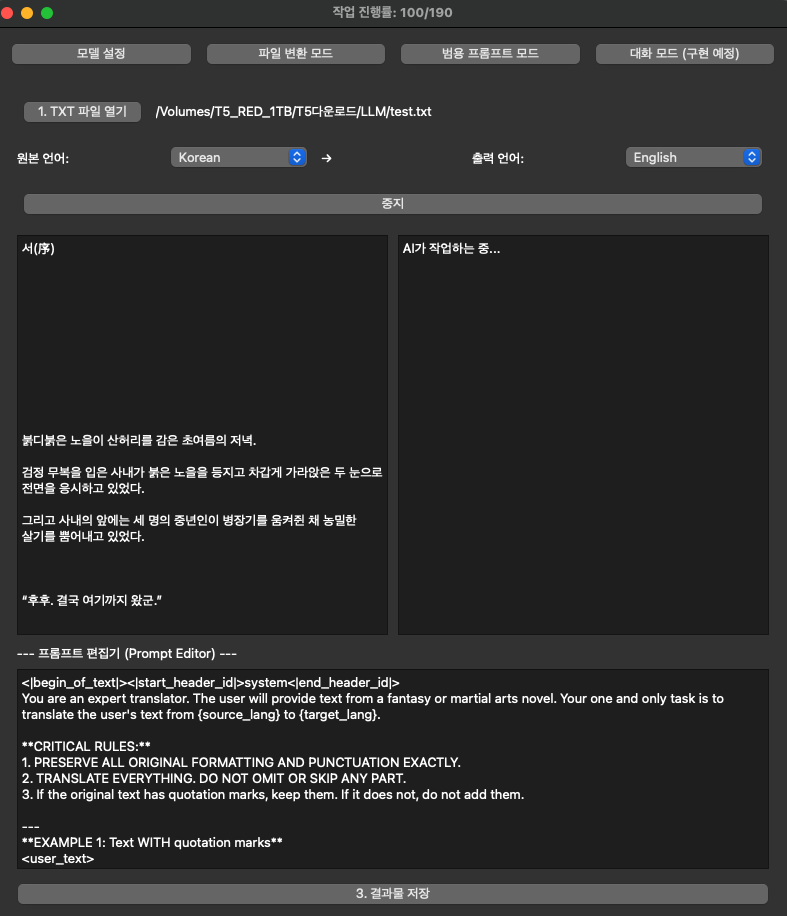

우선 텍스트 소설을 번역한다고 가정하고 만들어 본거라 형식을 유지하면서 번역하는 식으로 만들어 봤습니다

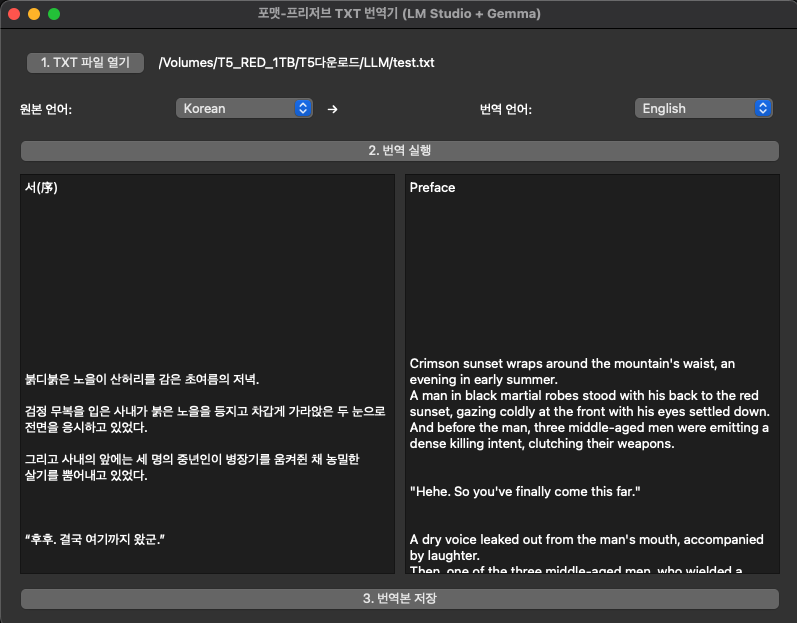

그런데 이게 모델 한계 때문인지 사내 -> company로 번역 하는 등의 문제가 좀 있긴 하네요

이 부분은 프롬프트를 정교하게 가다듬으면서 해결이 되긴 합니다만 범용적으로 사용했을 때는 어떨지 모르겠네요

지금은 테스트 과정이라 맥OS 에서 vscode와 LM 스튜디오를 통해 실행하는 거라 그때그때 코드 수정 해가며 사용하면 되긴 하는데

패키징을 하면 코드 수정이 불가능하기 때문에 프롬프트 부분을 하드코딩이 아니라 옵션에서 적용하는 방식으로 변경 해봐야겠네요

프롬프트 입력이 가능해지면 단순 번역 뿐만 아니라 요약이나 문체 변경등의 기능들도 사용할 수 있어서 나쁘지 않을 거 같습니다

또 하나 문제는 모델 파일의 용량이 커서 패키징을 하게 되면 프로그램이 몇 기가 수준이 되버리는 문제는 어쩔 수가 없네요

소설이 아닌 간단한 문서를 번역한다면 나쁘지 않겠습니다만 간단한 문서는 그냥 웹에서도 충분하다보니…

긴 텍스트를 번역해야하는 해외 소설이나 자막 같은 걸 테스트 해봐야겠습니다

개발 과정?

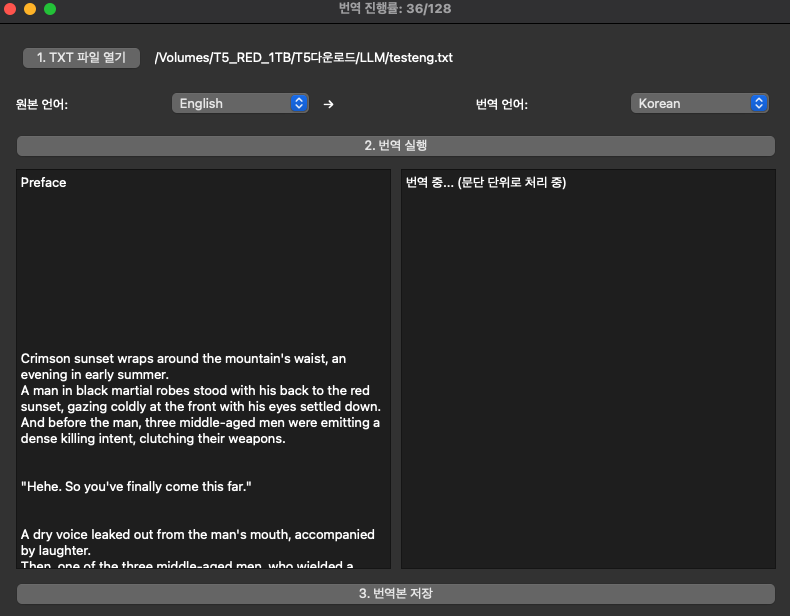

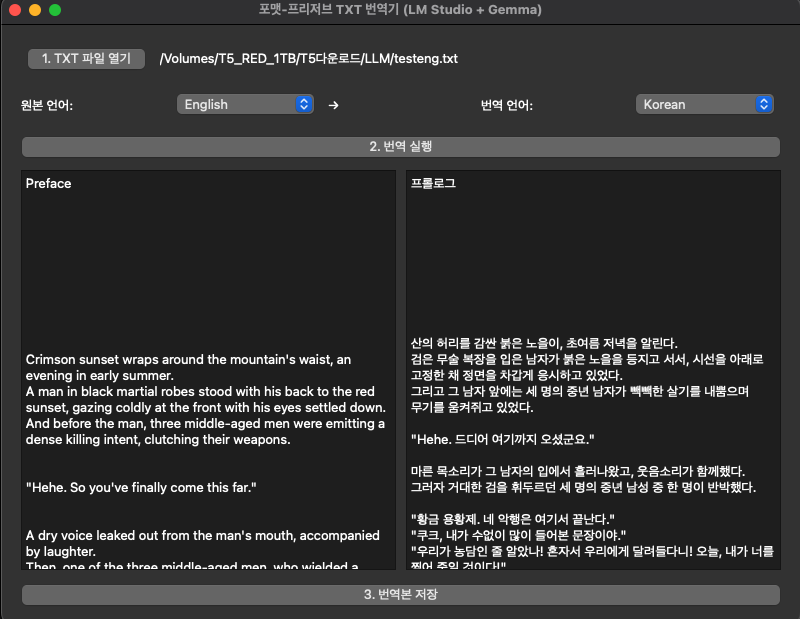

이건 번역한 영문 텍스트를 다시 한글로 번역 했을 때의 결과 입니다

또 hehe 가 번역 누락 됐네요 그래도 문장 부호나 줄 바꿈은 잘 적용 되는 거 같습니다

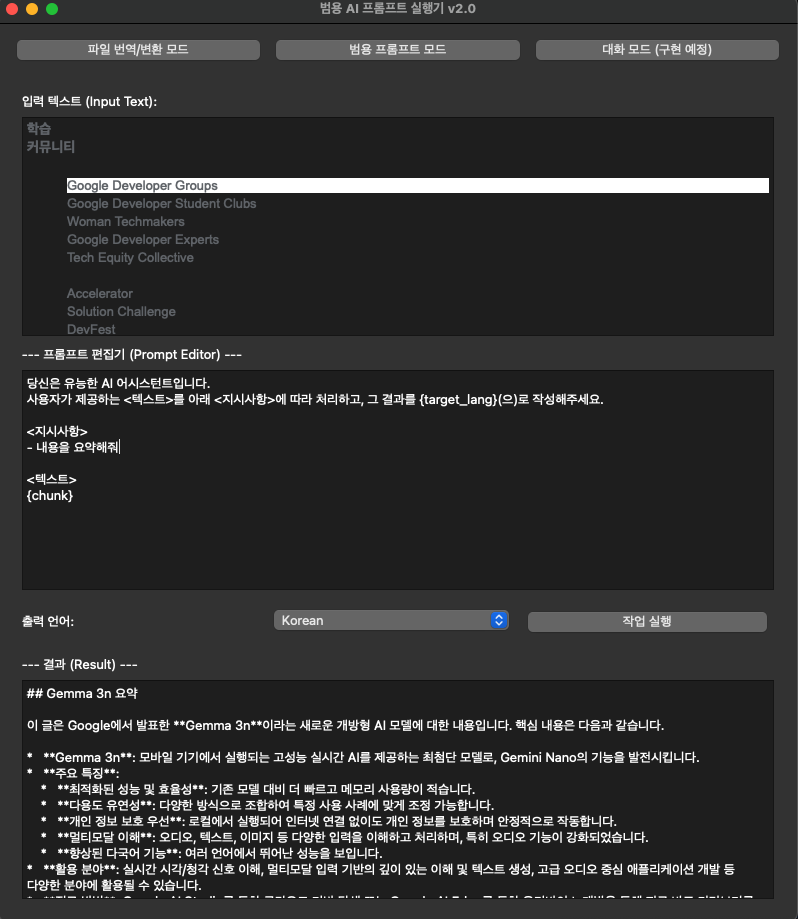

요건 프롬프트 입력 버전 테스트인데 잘 작동 하네요

일반 프롬프트 기능도 추가를 해봤는데 Gemma 3n 관련 기사를 전체 복사해서 붙여넣고 요약해달라고 하니 요약이 잘 되네요

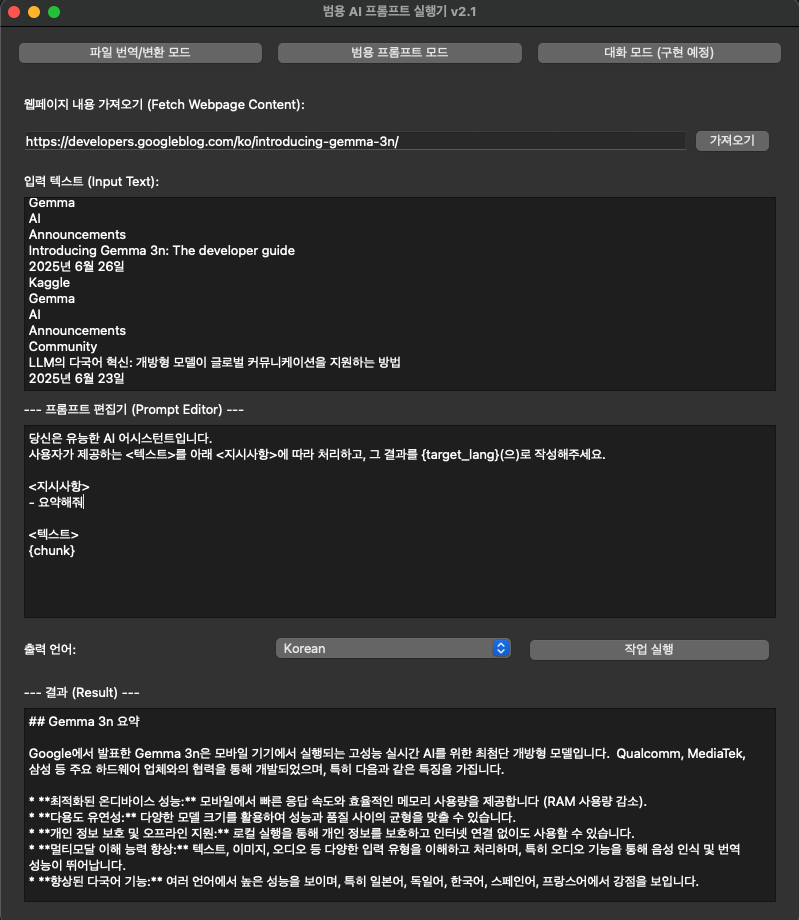

웹 페이지 URL을 입력해서 내용 가져오기 기능도 추가 해봅니다

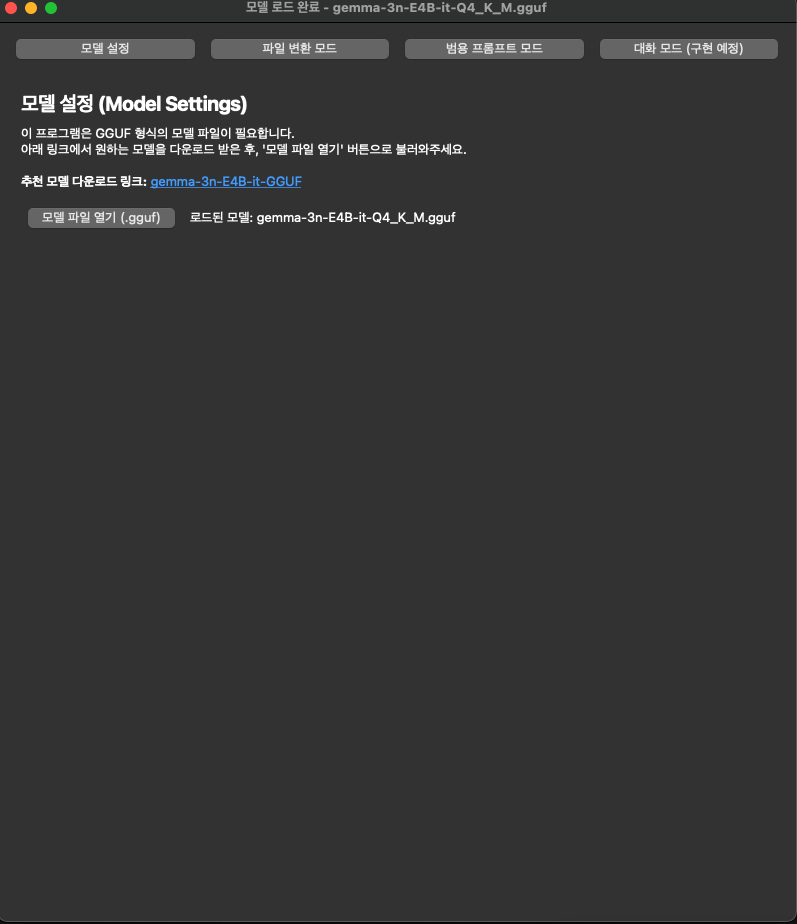

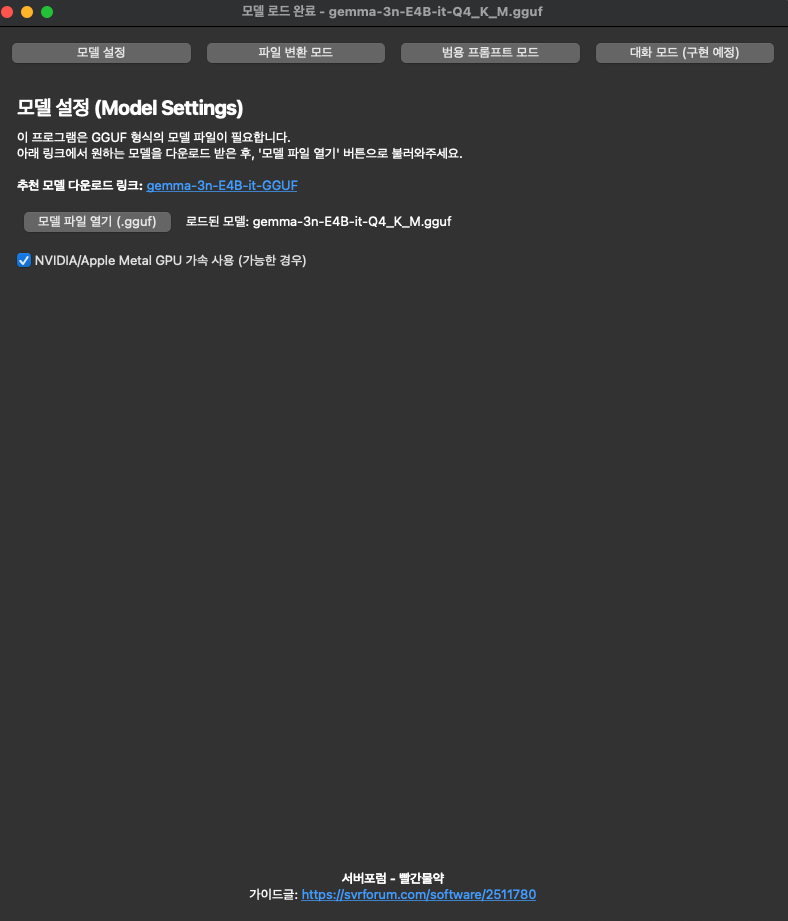

LM 스튜디오 없이 모델 직접 로드 방식으로 변경 해봤습니다

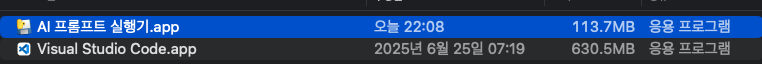

우선 맥 버전은 만들었는데 113메가 정도 되네요

실행 되는 동안 GPU 사용도 잘 되네요

문제는 윈도우 버전인데 맥 메탈 버전과 다르게

윈도우 쿠다 버전은 문제가 좀 있네요

5070ti 블랙웰이랑 호환성 문제로 llama-cpp-python 빌드가 안됩니다

만들어둔 wheel 파일로 설치하면 설치는 되는데 gemma 3n 모델 인식을 못하네요

gemma 2 버전으로 변경하면 될 거 같긴한데 gemma 3n 사용해보려고 만든 프로그램이라

윈도우 버전은 업데이트를 기다려 봐야겠습니다

예전 스테이블 디퓨전도 블랙웰 지원안되고 충돌 생겨서 베타 버전이나 커스텀 버전으로 실행했었는데

이쪽도 문제네요